Cos’è il crawling dei motori di ricerca?

Per comprendere a fondo la SEO e le dinamiche che la governano, è importante capire come un motore di ricerca analizza e organizza le informazioni che raccoglie.

Uno dei processi fondamentali che permette a Google, Bing, Yahoo e Yandex di indicizzare un contenuto è il cosiddetto crawling, ovvero il lavoro di un bot (o spider) volto ad analizzare a fondo una determinata pagina web.

Come funziona il crawling?

Il motore di ricerca utilizza il crawling per accedere, scoprire e scansionare le pagine di una risorsa web.

A svolgere questa attività sono i crawler, che scansionano tutti i link, come quelli indicati nella sitemap, e seguono (in alcuni casi) le indicazioni riportate nel file robots.txt: un documento che definisce le direttive per la scansione di un sito web.

Tramite il file robots.txt, ad esempio, possiamo suggerire al motore di ricerca di non analizzare/indicizzare determinate risorse del nostro sito, mentre tramite la sitemap, ovvero una lista delle URL, possiamo tracciare una mappa che faciliti il lavoro di scansione da parte del crawler.

Questi ultimi fanno uso di algoritmi e di regole per stabilire con che frequenza sottoporre ad una nuova scansione una specifica pagina e quante pagine del sito devono essere indicizzate.

Ciò è utile, ad esempio, per distinguere una pagina che viene aggiornata ciclicamente da una che rimane immutata. La prima verrà certamente scansionata più frequentemente.

In questo caso, uno dei concetti chiave è il crawl budget, ovvero l’insieme di risorse che il motore di ricerca decide di allocare a un determinato sito web.

Crawling di immagini, audio e video

Solitamente, il motore di ricerca scansiona e indicizza ogni indirizzo URL che incrocia sulla sua strada.

Anche per i file di tipo non testuale come immagini, file audio o video, il motore di ricerca è sempre più in grado di interpretarne il loro contenuto.

Tuttavia, è sempre opportuno rendere il nome del file e i metadati “parlanti”, quanto più chiari e comprensibili, al fine di favorire il lavoro del motore di ricerca e fare in modo che ogni risorsa sia indicizzabile e si posizioni al meglio nella SERP.

Il crawler su Link, Sitemaps e pagina di submission

Lo spider scopre nuove pagine scansionando quelle esistenti e seguendo i link interni ed esterni.

Questi indirizzi vengono aggiunti alla lista dei file da analizzare dal bot in un secondo momento.

Con questo processo, il motore di ricerca trova sempre nuove pagine dal web, che a loro volta linkano ad ulteriori URL.

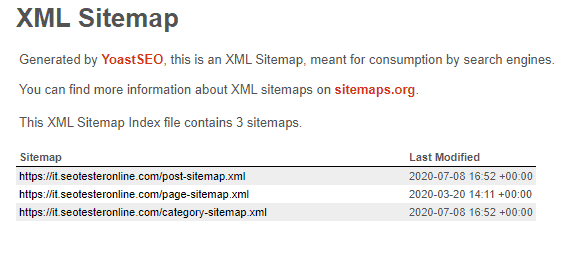

Un altro modo per riconoscere nuove pagine web è la scansione delle Sitemap che ricordiamo essere una lista delle URL creata per fornire al bot un elenco delle pagine scansionabili.

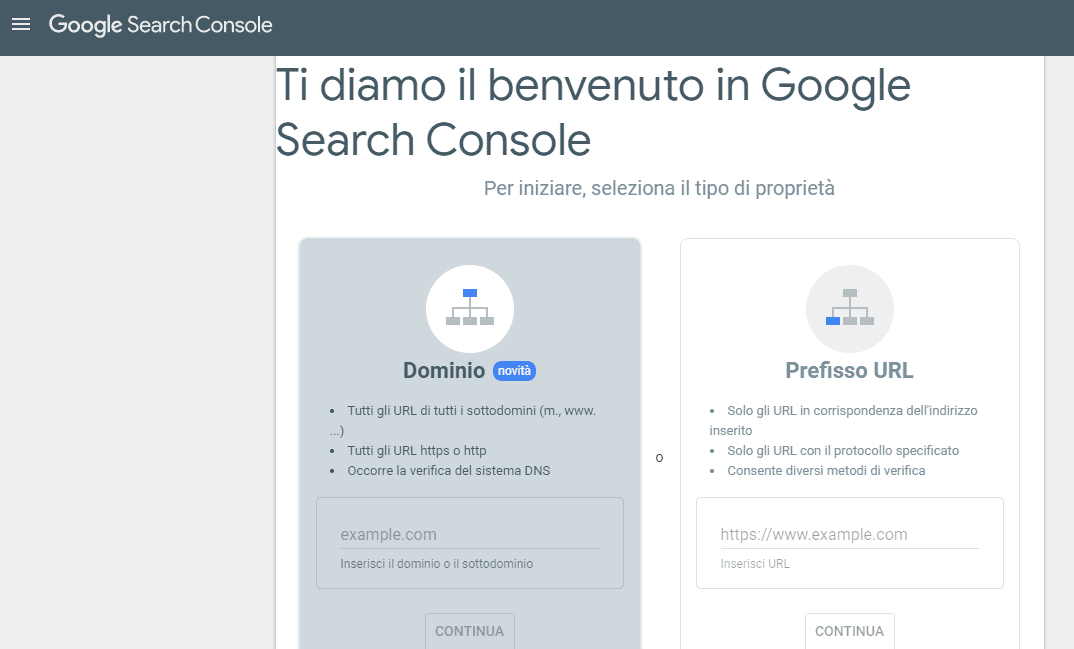

Una terza possibilità è l’invio manuale delle pagine al motore di ricerca.

Si usa questa pratica quando si pubblicano nuovi contenuti, oppure se si aggiornano e si vuole ridurre il tempo necessario per far notare a Google l’update.

Per farlo ti basterà usare Google Search Console.

Va precisato, però, che questa strada è percorribile solo quando si vogliono inviare una manciata di pagine (immaginate di dover sottoporre manualmente migliaia di URL uno per uno).

Diversamente, per grandi volumi di URL, Google preferisce l’utilizzo delle Sitemap XML.

Come funzionano i motori di ricerca?

Senza ombra di dubbio, i motori di ricerca sono affascinanti. I loro algoritmi sono ogni giorno sempre più complessi e non è semplice (a volte è addirittura impossibile) comprendere a pieno come funzionano.

Se vuoi saperne di più, ti consigliamo di leggere il nostro articolo sulle fasi di Scansione, Indicizzazione e Posizionamento dei motori di ricerca.