SEO Tecnica

6 migliori Hosting Web attivi in Italia

In questo articolo analizziamo i migliori Hosting Web presenti nel panorama italiano, evidenziando i...

SEO Tester Online

Settembre 6, 2022

Hosting e SEO: 7 consigli per ottenere risultati performanti

La relazione tra Hosting e SEO non è diretta, eppure è la base per avere un sito web performante. ...

Elena Parise

Maggio 27, 2022

Come creare URL SEO Friendly

Nella SEO sono i dettagli a fare la differenza. Leggi l'articolo per capire come rendere i tuoi URL ...

SEO Tester Online

Marzo 30, 2022

Guida al file Robots.txt: cos’è e perché è così importante

Come si crea un file Robots.txt e dove inserirlo? Scoprilo in questo breve articolo!...

SEO Tester Online

Gennaio 14, 2022

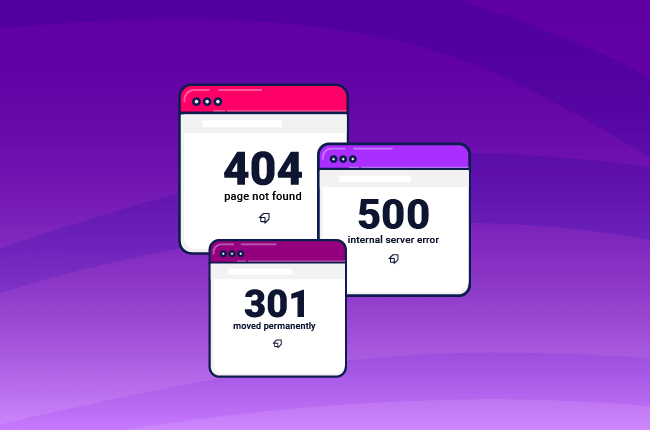

Guida ai Codici di Stato HTTP

Quali sono i codici di stato HTTP da controllare e ottimizzare per migliorare la SEO del tuo sito? L...

SEO Tester Online

Gennaio 5, 2022

Sitemap XML: cos’è, come crearla ed inviarla a Google

Qual è la tipologia di Sitemap XML che fa per te e per il tuo sito? Scoprilo leggendo questa guida ...

SEO Tester Online

Novembre 10, 2021